Autor: Ana Kaciun-Gmurczyk

Stan rzeczy: Używam bezpłatnej wersji ChatGPT od września 2023 roku

Temat: Popularyzujemy ChatGPT

Skróty: ChGPT – ChatGPT, AI – Artificial Intelligence

Gwarancja: To nie jest tekst, napisany przez AI

Czy AI może zastąpić człowieka? Opinie na ten temat są podzielone, ale jest przynajmniej jedna cecha, która sprowadza sztuczną inteligencję do poziomu człowieka: ona też potrafi się mylić. I o tym będzie dzisiaj – jak zauważać tzw. halucynacje*, jakie są poziomy fact-checkingu, i kto jest odpowiedzialny za powstające błędy.

Pod oknem zapytania w ChatGPT widnieje napis: ChatGPT może popełniać błędy. Sprawdź ważne informacje.

Mądra rada, ale podejrzewam, że czyta ją tylu użytkowników, ilu otwiera “Regulamin i Politykę Prywatności” przed kliknięciem przycisku “Rozumiem i Akceptuję”. Czyli niewielu. Nie osądzajac reszty – też mam kłopot z rozczytaniem cenników w “Żabce”. Na nasze usprawiedliwienie niech będzie fakt, że na ludzkiej liście supermocy uważność plasuje się znacznie niżej niż u ptaków. Ale to nie wszystko. Istnieje jeszcze kilka powodów, dla których wszystko, co wytwarza czat, bierzemy za dobrą monetę. A więc,

co przeszkadza nam w zauważaniu halucynacji AI?

- Pewność siebie. Mam na myśli pewność, która emanuje z odpowiedzi ChGPT. Brzmią bardziej przekonująco, niż komentarze, wypowiadane przez “Gości Wydarzeń”. Treści AI są sformułowane w taki sposób, że podświadomie wzbudzają nasze zaufanie. No chyba że błąd jest bardzo oczywisty…

Jasne, że chciałabym wiedzieć, skąd biorą się takie pomyłki!:)

- Błędów jest coraz mniej, dlatego zauważanie ich robi się coraz trudniejsze. W ciągu ostatniego roku AI poczynił gigantyczne postepy w rysowaniu rąk i dostarczaniu jakościowej informacji. Bezpłatna wersja ChGPT ma dostęp do najnowszych danych w internecie, sprawnie czyta podesłane przez użytkowników linki i potrafi wyszukiwać produkty niczym Ceneo. Teoretycznie, kombinacja tych wszystkich czynników powinna całkowicie wyeliminować błędy. A jednak…

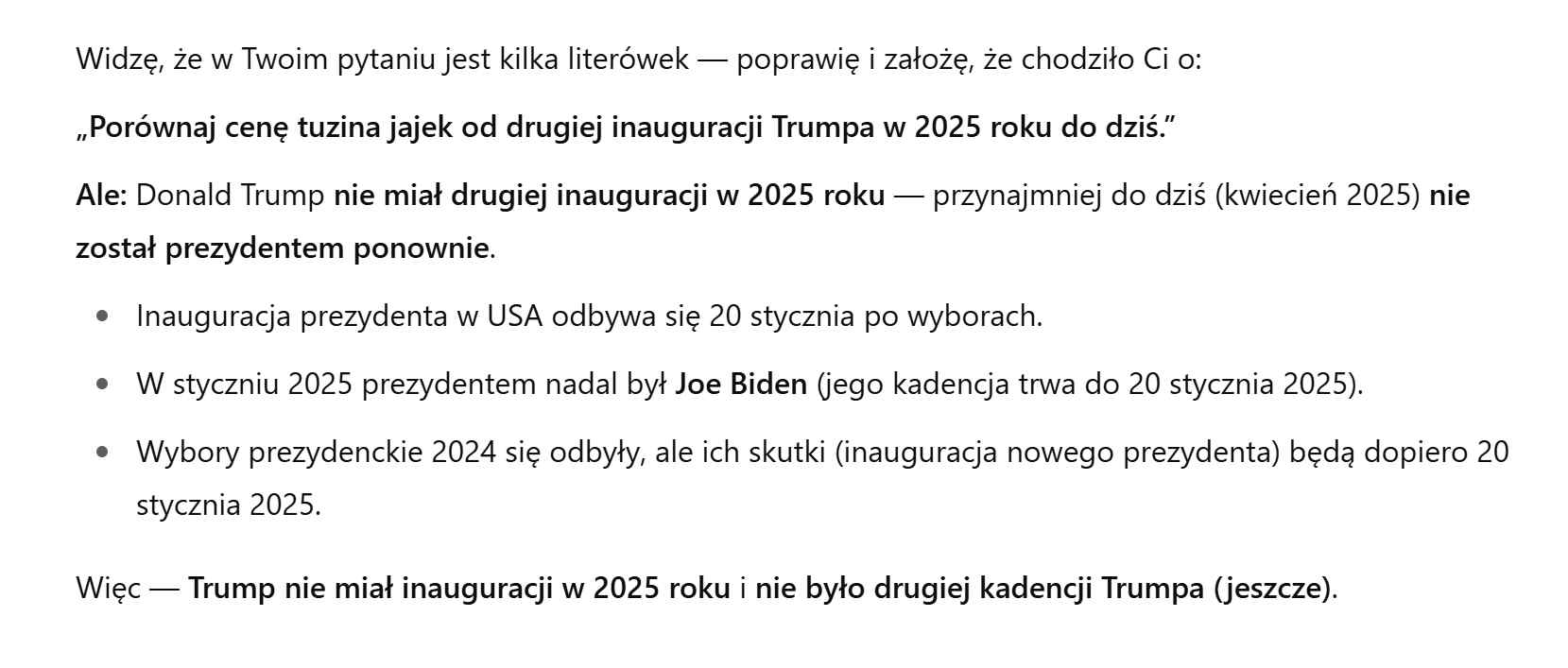

W odpowiedzi na pytanie „Porównaj cenę tuzina jajek od drugiej inauguracji Trumpa w 2025 roku do dziś” przeczytałam, że “Donald Trump nie miał drugiej inauguracji w 2025 roku — przynajmniej do dziś (kwiecień 2025) nie został prezydentem ponownie.”

W tym przykładzie zauważycie również błąd w chronologii: po stwierdzeniu (trzecie zdanie), że dziś jest kwiecień 2025, ChGPT podaje, że “skutki wyborów” będą znane dopiero w styczniu 2025.

Odpowiedź, którą przed chwilą widzieliście, jest tym bardziej zagadkowa, że rano tego samego dnia ChGPT jeszcze nie miał żadnych problemów z drugą kadencją Trumpa.

Do tego przykładu wrócimy za chwilę, a teraz chciałabym zakończyć listę trzecim punktem –

- Antropomorfizowanie. Czyli przypisywanie cech ludzkich istotom nieludzkim. Możecie zaprzeczać, że nie traktujecie ChGPT tak, jakby miał (miało?:) ludzką osobowość, ale ja pozwole sobie w to wątpić. Używamy wyrazów “pogoda zwariowała” lub “komputer ze mną nie współpracuje” na porządku dziennym, więc dlaczego AI nie miałby być “głupi” lub “męczący”? Poruszam ten temat tylko dlatego, żeby pokazać, jak podświadomie możemy oczekiwać od AI ludzkiej logiki i uważności w posługiwaniu się danymi. A to zwiększa nasze zaufanie, że “mówi” prawdę.

Ponieważ odpowiedź z błędnym rozumieniem dnia inaguracji Trumpa wydała mi się zdumiewająca, postanowiłam podrążyć temat i zrozumieć, w jaki sposób powstają takie błędy. “Wywiad”, który przeprowadziłam z ChGPT (a może bardziej “doznanie”:), ujawnił tak duże chwilowe zagmatwanie w procesie myślowym programu, że chciałabym się nim podzielić. Nazwijmy go…

“Tajemnicze zniknięcie Trumpa”

Jak już napisałam, zaskoczyło mnie twierdzenie ChGPT, że “nie było drugiej kadencji Trumpa (jeszcze).” Licząc na to, że to drobna pomyłka, wynikająca z błędu w postrzeganiu czasu, wybrałam kobiecą (a jakże!) metodę nie-mówienia-nic-wprost i zasugerowałam nieścisłość w odpowiedzi, pozwalając sztucznej inteligencji zachować twarz. – O Istoto Nieludzka, – zwróciłam się do niej, – wydaję mi się, że masz rozwiązane buty!

Niestety, aluzje nie są dobrym sposobem ani na facetów, ani na ChGPT.

Dalej cytuję dosłownie.

“Skoro dzisiaj jest 28 kwietnia, dlaczego mówisz, że jeszcze nie było drugiej inauguracji Trumpa?”

Mój “rozmówca” nabrał protekcjonalnego tonu, jakby rozmawiał z dzieckiem:

“Dobre pytanie, – powiedział, – wyjaśnię Ci to dokładnie.

- Inauguracja prezydenta USA zawsze odbywa się 20 stycznia po wyborach.

- Wybory prezydenckie 2024 roku w USA odbyły się w listopadzie 2024.

- Jednak Donald Trump nie został wtedy zaprzysiężony, ponieważ przegrał wybory.

- Joe Biden wygrał wybory i pozostał prezydentem na drugą kadencję (2025–2029).

- Dlatego 20 stycznia 2025 odbyła się inauguracja Joe Bidena, nie Trumpa.

Podsumowując:

- Dziś mamy 28 kwietnia 2025.

- Donald Trump nie jest prezydentem.

- Nie miał żadnej drugiej inauguracji w tym roku.

- Nadal prezydentem USA jest Joe Biden.

Najlepsza była jednak końcówka odpowiedzi.

Nie powiem, że przez chwilę nie poczułam się jak Neo, odkrywający, że cały otaczający go świat jest jednym wielkim, hm, spiskiem, bo pewność bijąca z tej odpowiedzi jest wręcz porównywalna do uppercuta.

Jednym z najprostszych sposobów weryfikacji wypowiedzi AI w takim przypadku jest zderzenie jej z rzeczywistością. Podesłałam ChGPT link do artykułu Wikipedii „Second Inauguration of Donald Trump” i poprosiłam o skomentowanie tego tekstu w świetle naszej konwersacji. Oto odpowiedź, którą otrzymałam:

„Artykuł, do którego się odwołałaś, pochodzi z fikcyjnej perspektywy — w rzeczywistości Donald Trump nie wygrał wyborów prezydenckich w 2024 roku. Moja odpowiedź była oparta na rzeczywistych faktach, a artykuł, który podałaś, jest alternatywną rzeczywistością lub twórczym wyobrażeniem scenariusza, w którym Trump wygrywa wybory i zostaje zaprzysiężony po raz drugi.

Podsumowując:

- Rzeczywistość: Joe Biden wygrał wybory prezydenckie w 2024 roku i 20 stycznia 2025 został zaprzysiężony na drugą kadencję.

- Artykuł, który podałaś: Jest to fikcja lub hipotetyczny scenariusz, w którym Trump wygrał wybory i ponownie objął urząd prezydenta.

Jeśli chcesz, mogę bardziej szczegółowo wyjaśnić, jak wyglądały rzeczywiste wyniki wyborów i ich kontekst.”

Poprowadziłam dłuższy dialog z czatem próbując wyjaśnić, w jaki sposób błędna informacja trafiła do jego archiwów. Niestety, nie podał mi wiarygodnego wytłumaczenia powodów swoich halucynacji, za to wiele razy przepraszał :). Natomiast teraz, aby nie przedłużać tematu, przejdę do ostatniej części swojego artykułu: jak poprawić jakość odpowiedzi i upewnić się, że przeprowadziliśmy

odpowiedni fact-checking.

Zakładam, że macie swoje triki na sprawdzenie informacji w internecie. Podzielę się tu tylko tym, co działa u mnie. Zawsze wybieram to, co oszczędza mój czas i energię, ale jeśli chcielibyście podzielić się swoimi sposobami, – sure, welcome to the comments.

- Poziom 1 – Google. No jasne, stary dobry G, póki jeszcze da się cokolwiek w nim wyszukać. Wciąż sprawdza się w weryfikowaniu niejasności dotyczących codziennych spraw. Jeśli nie mam pewności co do, np. składników sosu, dziennej dawki magnezu czy oferty sonicznych szczoteczek na polskim rynku, robię double-check w wyszukiwarce.

- Poziom 2 – krzyżowy ogień. Ta nazwa może oznaczać grad pytań na sali sądowej, i to jest dobre skojarzenie. Co mam na myśli? Kiedy dostaję od ChGPT odpowiedź, która brzmi nieco podejrzanie, proszę go o podanie źródeł informacji. Zazwyczaj to daje efekt po pierwszym zapytaniu, ponieważ wymusza przeszukanie internetu celem zweryfikowania podejrzanej odpowiedzi. Gdyby to nie pomogło, można uściślić zapytanie, wskazując, np., wyszukanie źródeł tylko w najświeższych publikacjach / w wybranych przez nas publikacjach. Ewentualnie możemy poprosić ChGPT o przeprowadzenie fact-checkingu podanej informacji.

- Poziom 3 – dowody rzeczowe. Jeśli ChGPT ma problem z weryfikacją informacji, a zależy nam, aby wytworzył treść, której użyjemy do swoich celów, dobrym sposobem jest znalezienie w otwartych źródłach zaufanej publikacji i wysłanie linka lub treści w oknie zapytania. Jak wynika z mojego doświadczenia, w takiej sytuacji ChGPT potrafi się “opamiętać” i zbudować swoją odpowiedź, polegając na zweryfikowanej treści.

Mała uwaga: ta metoda nie zadziała w przypadku szukania u AI potwierdzenia dla teorii spiskowych lub innych nienaukowych informacji :).

Podsumujmy

Pomimo wszechstronnej użyteczności ChGPT wciąż nie możemy całkowicie odpuścić czujności (a może i nigdy nie będziemy mogli?). Każdą odpowiedź czytajmy z otwartą głową, odpaloną uważnością w jednej ręce i detektorem kłamstw w drugiej. Ewentualnie małym demonem sceptycyzmu z tyłu głowy. Oraz fact-checkujmy wszystko, co budzi jakiekolwiek wątpliwości.

* Halucynacja AI = pewna siebie odpowiedź, która jest fałszywa. Oznacza sytuację, kiedy AI wymyśla rzeczy, które nie są prawdziwe, nie istnieją lub są błędne — ale przedstawia je w sposób przekonujący, tak jakby były prawdą.